Дипфейк: невинная технология для развлечения или угроза современному обществу?

Вход

Авторизуйтесь, если вы уже зарегистрированы

(Голосов: 24, Рейтинг: 4.46) |

(24 голоса) |

Аспирант Факультета гуманитарных и социальных наук РУДН

Эксперт по вопросам международного регулирования искусственного интеллекта и сквозных технологий

Стремительное развитие дипфейк–технологий в последние годы существенно упростило и расширило возможности различных манипуляций с аудиовизуальным контентом. В ряде стран уже зафиксированы случаи использования модифицированного контента в судопроизводстве в качестве вещественного доказательства. Однако любые технологические прорывы, и дипфейки здесь не исключение, ставят под сомнение истинность или достоверность таких доказательств. Видоизмененные (синтетические) изображения/видео стали настолько достоверны и убедительны, что их все сложнее разделять на, собственно, фейк, т.е. подделку и на реально имевший место факт. Сегодня дипфейки — это инструмент шантажа, информационных и политических диверсий, способ «легендирования» недостоверных событий и новостей, диффамации и искусственной дестабилизации политической обстановки в отдельно взятой стране или обществе. Тем не менее у дипфейков есть и оборотная сторона — значительный положительный потенциал для образовательных, культурологических или развлекательных целей.

Дипфейк-технологии не нужно бояться, их нужно знать. Информированность — ключ к минимизации рисков и угроз, игнорирование — прямая дорога на «минное поле» многочисленных дипфейк-ловушек. Так или иначе цифровизация нашей жизни будет продолжаться. В идеальном сценарии каждый новый технологический виток будет происходить после нивелирования негативных проявлений предыдущего. Однако на практике так происходит все реже. Повышение собственной цифровой грамотности позволит избежать подавляющего большинства технологических «мышеловок», поскольку практически весь деструктивный контент, в котором все большее значение отводится дипфейкам, ориентирован на неискушенного пользователя. Любой массовый синтетический контент только хочет казаться неотличимым от настоящего. На самом деле он имеет множество технологических и контекстных (логических) изъянов, увидеть которые не так сложно. Как в современном кинематографе мы с легкостью различаем реальных и «нарисованных» героев, какие бы совершенные технологии нам ни показывали, так и в жизни любой человек способен распознать абсолютное большинство дипфейков. Пока на технологическом и государственном уровнях не будет выстроен надежный периметр безопасности в сфере дипфейк-технологий, наша защита будет во многом зависеть от нас самих.

Введение

Новая цифровая реальность последних лет, в большинстве технологических решений которой ядром выступает искусственный интеллект (ИИ), существенно исказила восприятие человеком разницы между реальностью и вымыслом. Один из главных «стирателей» такой грани — дипфейк-технологии, которые можно охарактеризовать как методику автоматизированного, т.е. машинного синтезирования аудиовизуального цифрового контента (изображений, аудио, видео и даже текста) с целью создания видоизмененного и при этом максимально реалистичного контента. Сфера применения дипфейков обширна и ограничивается, по сути, лишь периметром самой «цифровой вселенной», а в некоторых случаях даже выходит за ее пределы (например, распространенная практика автоматизированных колл-центров использовать в разговорах с людьми «очеловеченный» искусственный голос или озвучка «роботом» рекламных объявлений на радио). В свете постоянно ускоряющейся цифровой трансформации общества, посягающей на все большее количество ранее сугубо «аналоговых» сфер жизни, поле для возможного произрастания «семян» дипфейка также стремительно расширяется. Параллельно с этим процессом множатся и риски как на уровне отдельно взятого человека, так и в масштабе государства.

Краткая история дипфейка

Одна из самых известных фотографий бывшего президента США А. Линкольна, опубликованная уже после его смерти в 1865 г., — далекий предок современного дипфейка. На снимке голова американского президента наложена на фотореалистичную гравюру 1852 г. с изображением вице-президента США Дж. Кэлхуна, которая была изготовлена на основе ранее написанного портрета маслом [1]. Имя создателя подделки история не сохранила, однако известно, что художник был не только талантливым, но и тонко чувствовавшим актуальный политический момент. Он не просто «приклеил» голову А. Линкольна c работы известного фотографа М. Брэди (кстати, именно это изображение впоследствии появится на пятидолларовой купюре), но и отредактировал документы в кадре, на которые опирается рука Дж. Кэлхуна. В оригинальной гравюре с вице-президентом они были о свободной торговле и суверенитете штатов, а в новой версии, уже с учетом итогов гражданской войны в США, — о Конституции, союзе штатов и отмене рабства. Причина появления этого, пожалуй, первого задокументированного дипфейка с известной личностью весьма прозаична: А. Линкольн на момент смерти воспринимался значительной частью американцев как национальный герой, однако не любивший фотографироваться президент оставил после себя очень мало изображений и ни одного «героического» фото. Дипфейк неизвестного автора успешно восполнил этот «культурологический пробел».

Один из примеров дипфейк-технологий XIX в. — стилизованное под фотографию синтетическое, т.е. вымышленное изображение Президента США А. Линкольна (слева) на основе реально существовавшей донорской гравюры. Источник: https://birdinflight.com/ru/mir/20170626-lincoln-fake.html

История актуальной итерации дипфейка началась в 2014 г., когда студент Стэнфордского университета Й. Гудфеллоу разработал программный метод получения новых материалов (текстовых или звуковых) с помощью уже собранной базы данных. Однако потребовалось еще три года, чтобы этот метод получил свое теперь уже известное во всем мире название — «дипфейк». В 2017 г. анонимный пользователь под одноименным псевдонимом «deepfakes» (дипфейки) загрузил на популярный форум с элементами соцсети «Reddit» видеоролик порнографического содержания, в котором «снялись» голливудские звезды. Видео вскоре было удалено, однако, поскольку «Интернет помнит все», то представленная широкой аудитории «во всей красе» технология замены лица, основанная на инструментах машинного обучения и глубокого обучения [2], мгновенно привлекла внимание СМИ, «завирусилась», разойдясь по различным форумам и соцсетям. Уместно подчеркнуть, что по некоторым оценкам, 95–96 % всех создаваемых дипфейк-видео — это порнография в том числе с целью мести и/или дискредитации как известных личностей, так и рядовых граждан. С течением времени ее удельный вес в общем объеме синтетического видео остается достаточно стабильным. Вероятно, каков спрос, такое и предложение…

Выпустив джина из бутылки, то есть позволив новой «забаве» вызвать нешуточный интерес людей по всему миру, многие транснациональные цифровые платформы, в том числе Twitter, в итоге осознали возникшие риски. В 2018 г. ими была предпринята попытка очистить виртуальные информпотоки от каких-либо ссылок и упоминаний дипфейк-технологий, естественно, безуспешно [3]. Введенные ограничения и запреты лишь усиливали интерес интернет-пользователей. Одновременно с этим совершенствовался и облегчался инструментарий создания синтетического контента. За несколько лет порог «входа» в технологический процесс производства дипфейков радикально снизился. Сегодня уже не нужно быть программистом высокой категории или специалистом в сфере Data Science. Достаточно обладать навыками компьютерной грамотности чуть выше среднего и уметь оперировать соответствующим типовым набором программного обеспечения с открытым исходным кодом от компаний-поставщиков типа «Google» и «NVidia». Это под силу уже многим старшеклассникам.

Что такое дипфейк и с чем его едят?

Дипфейк (от англ. deep fake) — комбинация двух терминов: «глубинное обучение» (от англ. deep learning) и «подделка, ложь» (от англ. fake). Необходимо отметить, что количество одних только видео-дипфейков, циркулирующих в Интернете, стабильно увеличивается вдвое каждые полгода. Их общее число вряд ли поддается подсчету. По данным некоторых иностранных экспертов, всего за два года существования в относительном доступе инструментов по производству дипфейков только «очевидного» вредоносного видеоконтента выявлено свыше 85 тыс. единиц. При этом уместно предположить, что синтетический контент всех видов (видео, аудио, изображения и текст) может исчисляться сотнями миллионов единиц, одномоментно находящихся в цифровом пространстве.

Для ответа на вопрос, что же такое дипфейк с технологической стороны вопроса, рассмотрим два самых распространенных его вида: видео и аудио. В основе процесса создания дипфейк-видео лежит работа генеративно-состязательных нейросетей (от англ. generative adversarial networks — GANs), анализирующих колоссальную по объему для человека, но не машины, выборку данных с целью изучения выражений лица «объекта», его характерных черт и мимики в целях дальнейшей имитации вышеперечисленных признаков. Процесс имитации состоит в том, что два человеческих образа «погружаются» в алгоритм глубокого обучения, который изучает их по множеству различных параметров (используется метод картографии лица) с целью максимально естественной замены одного лица на другое. Как правило, есть прямая взаимосвязь: чем больше анализируется разнообразного исходного видеоматериала, тем выше итоговое качество подделки.

С аудио-дипфейками процесс создания в целом аналогичен. Необходимо иметь аудиозаписи человека (чей голос планируется «клонировать») в различных ситуациях: интервью, публичные выступления, телефонные голосовые сообщения, реплики из бытовых разговоров и т.д. Они разбиваются на микрофрагменты и направляются на изучение алгоритмам глубоко обучения. Сейчас для создания подделки среднего качества достаточно 10–15 минут исходных данных. Однако, чтобы синтетический голос правильно или в характерном для «оригинала» ключе делал ударения, паузы, использовал междометья и пр. потребуется несколько часов разнообразных аудиозаписей. В этом случае происходит самое натуральное клонирование или синтез голоса. Его практически невозможно отличить от настоящего, не имея специализированных программ и технологий, выявляющих подделку по мельчайшим звуковым аномалиям.

Феномен популярности дипфейков

Две главные причины бешеной популярности дипфейков у интернет-пользователей, политтехнологов, а также мошенников и экстремистов различного толка — относительная легкость создания и сильнейший воздействующий эффект. Фантастические блокбастеры в кинотеатрах с легкостью собирают кассу в сотни миллионов долларов как раз по причине зрелищности, хотя люди прекрасно понимают, что им по большей части показывают сплошные комбинированные съемки и дипфейки, а не реальные «живые» кадры. Пока создание правдоподобной видео-картинки было возможно лишь на крупных киностудиях, эти технологии, с «заклепочной» точки зрения, мало кого волновали, интересен был лишь итоговый развлекательный эффект в кинозале. Что-то похожее можно наблюдать и в контексте аудио-дипфейков. Когда в 1985 г. известный британский астрофизик С. Хокинг окончательно лишился возможности говорить, ему на помощь пришла корпорация «Intel» со своим синтезатором речи Speech Plus CallText 5010 (робот «с американским акцентом» читал набранный ученым текст). Этот «металлический» голос, который даже не умел делать ударения и выдерживать паузы, стал визитной карточкой С. Хокинга: десятки лет с его помощью читались лекции и озвучивались научно-популярные фильмы. Ученый отказывался его менять до самой смерти в 2018 г., несмотря на уже имевшиеся многочисленные улучшенные варианты. Таков был упомянутый воздействующий эффект как на самого С. Хокинга, так и на его многомиллионную аудиторию по всему миру. Однако, как и в случае с киноиндустрией, общественный интерес к технологиям синтеза голоса оставался на уровне бытового любопытства, поскольку не было доступного инструментария для личного творчества.

Все изменилось с ускорением цифровизации в последние 5–7 лет. Появились достаточные вычислительные мощности с соответствующим программным обеспечением, доступные для приобретения и использования огромному числу людей во всем мире, а также высокоскоростной Интернет. Еще на заре современных «гражданских» дипфейк-технологий, в январе 2018 г., на упоминавшемся сайте «Reddit» к популярному приложению fakeApp давалась пошаговая инструкцию создания собственных дипфейк-видео. Тогда же появились коммерческие приложения и программное обеспечение для генерации любых синтетических аудио.

Две стороны дипфейк-медали

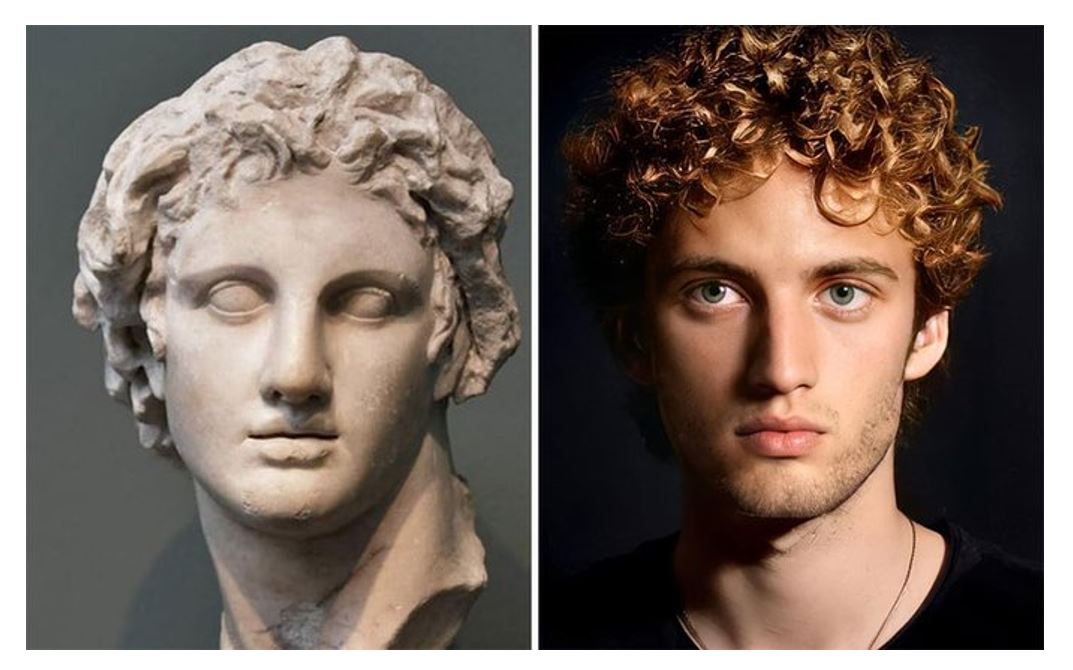

Возможно, на первый взгляд покажется неочевидным, но в ряде случаев дипфейки могут принести существенную пользу обществу. Взять, к примеру, сферу образования, которая в последние годы существенно наращивает интерактивно-цифровую составляющую. Если уж что-то и нужно оцифровывать в учебном процессе, так это то, что невозможно воспроизвести или показать учащимся традиционным «аналоговым» способом. Многим школьникам уроки истории показались бы намного интереснее, если бы они иллюстрировались качественными дипфейками великих людей прошлого: правителей, военачальников, деятелей науки и культуры. Они могли бы рассказать часть школьной программы как свою личную историю. Этот же пример уместно спроецировать и на уроки литературы. Представьте, насколько увлекательным станет знакомство с классикой русской литературы, если поэты «золотого века» смогут «лично» декламировать свои только что сочиненные стихи.

Образ Александра Македонского, воссозданный с помощью дипфейк-технологий. Источник: https://4pda.to/2022/02/27/397140/khudozhnik_i_nejroset_pokazali_istoricheskikh_lichnostej_v_sovremennom_oblike/

Другая сфера применения аудиовизуальных дипфейков, доказавшая свой положительный эффект, — это упоминавшаяся ранее киноиндустрия. Обитатели исчезнувших миров прошлого, воображаемого будущего или далеких просторов галактики оживают на экране во многом благодаря возможности создания синтетических образов. Дипфейки дешевле в производстве и качественнее ранее активно использовавшихся SFX, VFX и CGI технологий. Кроме того, они позволяют омолаживать или даже воскрешать на экране уже умерших актеров.

Даже в индустрии моды и дизайна есть место дипфейкам. Различные узоры, рисунки, орнаменты играют важную роль в создании шаблона. С помощью технологии синтезирования образов модельеры и дизайнеры могут использовать комбинацию старого дизайна и орнамента для создания, к примеру, новой линии сумок (как раз в русле изначальной задумки Й. Гудфеллоу — синтезировать новое на базе известного старого). В итоге в процессе поиска свежих идей применение современных цифровых методов позволяет сэкономить время и деньги.

Этика ИИ в авангарде мировой повестки

На этом радужном фоне риски и угрозы бесконтрольного применения дипфейк-технологий выглядят намного внушительнее. Поскольку стержневая идея любых дипфейков — максимальная реалистичность и правдоподобность, то уже сегодня мы наблюдаем лавинообразный рост модифицированного контента, созданного с целью манипуляции сознанием как отдельно взятого человека, так и общества в целом. Один из самых распространенных и при этом легких дипфейк-способов изъятия денежных средств у населения — запись мошенниками голоса жертвы (главная задача состоит в том, чтобы добиться произнесения ключевых слов, таких как «да»), на основе которой генерируется типовая звуковая дорожка для «общения» с роботом службы поддержки банка. Грамотно синтезированная на базе ключевых фрагментов запись позволяет «достоверно» ответить на все вопросы робота для перевода средств на нужный мошенникам счет. Кроме того, известны случаи, вернее попытки, использовать синтетические аудиозаписи в качестве вещественных доказательств в суде. В 2019 г. в Великобритании состоялись слушания по делу об опеке над детьми, в ходе которых в качестве доказательства мать представила в суд поддельную аудиозапись с угрозами отца. К счастью, после экспертизы такое доказательство не было приобщено к материалам дела, однако это не означает, что в других случаях подобные «факты» будут также тщательно изучаться. Следует понимать, что возникающая необходимость серьезной экспертизы любых аудиовизуальных доказательств неминуемо будет затягивать ход судопроизводства, увеличивая соответствующие расходы и нагрузку на работников судебных и правоохранительных органов. Помимо этого, постепенно сформируется эффект «недоверия по умолчанию» к любым цифровым доказательствам. В недалекой перспективе это будет означать в буквальном смысле необходимость представлять в суд и другие уполномоченные инстанции верификацию или дополнительные гарантии реальности всех цифровых доказательств.

Намного более серьезные последствия бесконтрольного применения дипфейк-технологий видятся в политической и международной плоскостях. Известны случаи влияния дипфейков на политическую борьбу демократической и республиканской партий в США. Пожалуй, самый известный эпизод произошел в 2019 г., когда действующий на тот момент президент Д. Трамп, осознанно или нет, «разогнал» в личном Twitter-аккаунте дипфейк с одним из своих главных критиков — спикером Палаты представителей США Н. Пелоси. На видео представитель демпартии предстает в явно нетрезвом виде. С учетом существовавших на тот момент правовых лакун в регулировании дипфейков в США, ответственность за разразившийся скандал никто не понес. В том же году обращение к нации президента Габона А. Бонго сочли дипфейком (на фоне слухов о его тяжелой болезни), ставшее триггером к неудавшейся попытке государственного переворота и сбоям в работе Интернета в центральноафриканской стране. Явных доказательств того, что конкретное видео было дипфейком представлено не было, однако сама возможность применения в политических целях этой технологии привело к дестабилизации целой страны.

Если подняться еще выше, на наднациональный уровень, то можно легко представить себе ситуацию применения дипфейк-технологий с целью хаотизации целых регионов. В качестве наглядной иллюстрации можно привести весьма чувствительное к любому воздействию и традиционно взрывоопасное духовно-конфессиональное пространство. В странах Евросоюза до сих пор вспоминают события января 2015 г., когда в редакцию французского сатирического журнала «Charlie Hebdo» ворвались исламские радикалы, убив 12 и ранив еще 20 человек. Поводом для кровавой бойни послужила опубликованная журналом очередная карикатура на пророка Мухамеда. Всего лишь. Представьте, каковы могут быть последствия, если дипфейк-технологии начнут массово применяться в целях разжигания межконфессиональной вражды? Эскалация и всплеск насилия, возможно даже религиозные войны — это все более чем реально.

Дипфейк-технологии — инструмент ведения информационного противоборства в «гибридных войнах»

Цифровые сервисы, нанизанные на глобальную сеть Интернет, в последние годы превратились в мощный инструмент воздействия на сознание человека с целью формирования определенных поведенческих паттернов, политических, религиозных и идеологических воззрений. Социальные сети, мессенджеры и другие цифровые платформы, помимо декларируемых возможностей быстрого и удобного обмена информацией и организации взаимодействия людей на расстоянии, стали также неотъемлемой частью современных «гибридных войн». Согласно концепции последних, достижение геополитических целей (читай победы над врагом) связано уже не только с непосредственными боевыми действиями, но и с культивированием внутреннего протеста, социальной напряженности в фокусном государстве, а также взращиванием идеологически «правильного» поколения людей — опоры нового режима. Иными словами, речь идет о ведении прокси-войны руками и человеческими ресурсами противника на его же территории. В таких войнах дипфейки начинают играть одну из ведущих ролей за счет своего уже доказанного серьезного эффекта по формированию общественного мнения.

Весьма острой и пока еще нерешенной остается проблема распространения модифицированного аудиовизуального контента в СМИ и Интернете, порождающего феномен постправды. В контексте инициированного против России странами «коллективного Запада» информпротивоборства, в том числе с задействованием самых современных технологий на базе ИИ, особую актуальность приобретают средства внутренней защиты от таргетированного воздействия и обработки сознания граждан через имеющие огромную популярность в российской цифровой среде новостные сервисы, киноиндустрию, соцсети, маркетплейсы, видеоигры и интерактивный контент. В связи с этим возрастает значение отечественных ИИ-технологий, способных выявлять и ограничивать циркуляцию дипфейков. В случае интеграции защитных ИИ-алгоритмов в контур администрирования внутреннего информпространства появится реальная возможность содействовать поддержанию не декларативного, а реального баланса между правом человека на доступ к информации, в том числе иностранного происхождения, и правом государства на ее фильтрацию и удаление из национального «эфира» в интересах общества. Однако говорить о практических шагах на данном направлении пока еще преждевременно.

Технологическое и юридическое регулирование дипфейк-технологий

О глубине, прозрачности и «силе» ИИ в текущем моменте

Исходя из обозначенных выше угроз очевидно, что на текущем временном срезе дипфейк-технологии представляют серьезную угрозу не только для рядового человека, но и для архитектуры международной безопасности как таковой. По этой причине имеет смысл заострить внимание на мерах возможного регулирования дипфейков в целях минимизации урона от их применения. К счастью, на экспертном уровне уже разработан ряд технологических и правовых подходов.

Первый из них касается развития и внедрения «цифровой криминалистики», подразумевающей обнаружение дипфейков с помощью технических средств. К слову, в 2021 г. ученые из Университета Буффало разработали алгоритм, который с точностью в 94% вычисляет дипфейки по глазам человека на фотографии. ИИ-система умело определяет естественным ли образом свет отражается на роговице. Однако следует понимать, что даже при условии взрывного развития и внедрения алгоритмов по обнаружению дипфейков, загруженный пусть и на ограниченное время в сеть синтетический контент вполне способен нанести непоправимый ущерб, так как скорость распространения информации в Интернете сделает свое дело, охватив целевую или как минимум значительную часть аудитории.

Тем не менее отказываться от «цифровой криминалистики» не стоит. В дополнение к ней разработан метод нанесения цифрового «водяного знака» в случае обнаружения скрытых следов модификации графического контента. Это позволит избавить пользователя от необходимости самостоятельно верифицировать ту или иную запись, но и тут существуют сложности, которые препятствуют отнесению цифрового «водяного знака» к разряду идеального инструмента борьбы с дипфейками. Во-первых, эта технология должна быть запущена на многих цифровых устройствах, имеющих возможность генерировать, просматривать и слушать контент. Во-вторых, использование цифрового «водяного знака» должно быть предварительным условием для загрузки контента на наиболее популярные цифровые платформы, такие как Meta [4], Twitter, YouTube, TikTok, VK и др. Стоит признать, что владельцы и операторы цифровых платформ вряд ли станут добровольно внедрять цифровую аутентификацию до тех пор, пока данная мера не обретет обязательные юридические рамки. Значительная часть пользователей, генерирующих собственный (в том числе непроверенный) контент, аккумулирует вокруг себя аудиторию и, соответственно, умножает для цифровых платформ прибыль. Хайп в наше время очень хорошо конвертируется в реальные деньги.

Наиболее спорный и обсуждаемый технологический подход — «сервис подтвержденного алиби». Считается, что наиболее уязвимая группа населения в контексте дипфейк-технологий — это известные личности, дорожащие своей репутацией. В целях защиты им предлагается фиксировать свои повседневные действия на цифровой носитель — сам процесс называется «лайфлоггингом». Документируя в онлайн-режиме свою жизнь, человек с опорой на факты может доказать, чем он занимался в конкретное время и месте. Частные компании уже в ближайшем будущем планируют вывести на рынок носимые цифровые устройства с емким хранилищем и надежной аутентификацией записываемых данных, чтобы сделать «лайфлоггинг» более «комфортным» [5]. Такие сервисы должны взаимодействовать с наиболее известными новостными и социальными интернет-платформами в целях оперативного предоставления подтверждений или опровержений любого контента с участием конкретной личности.

С точки зрения классического права, создание или распространение значительной части дипфейков может классифицироваться как диффамация, мошенничество или незаконное присвоение образа (личности) человека, что предполагает административную, гражданско-правовую или даже уголовную ответственность. В теории можно криминализировать дипфейки, добавив соответствующие положения в гражданское, административное и уголовное законодательство. Однако в плоскости привлечения нарушителя к ответственности ситуация выглядит не столь однозначной, поскольку киберпреступник, как это часто бывает, в целях личной безопасности публикует вредоносный контент в чужой (иностранной) юрисдикции или через сеть анонимных посредников. В связи с этим актуальные тренды нормативно-правового регулирования в мире дрейфуют в сторону самоцензуры или саморегулирования со стороны цифровых платформ. В идеале они самостоятельно должны предпринимать достаточно усилий в целях идентификации и удаления дипфейков, а также любого иного потенциально вредоносного контента. Тем не менее на практике дело обстоит иначе. В глобальных экосистемах (например, под брендом «Alphabet») вместо законов, этнокультурных или религиозных традиций, за фактическое регулирование информпотоков, в том числе дипфейков, отвечают многостраничные «корпоративные нормы», «правила сообщества», а также некие «этические принципы». К их появлению ни государства, ни пользователи отношения не имеют, но обязаны соблюдать, если хотят иметь доступ и пользоваться полным спектром благ экосистем. В этом смысле мерилом «качества» и «приемлемости» любого синтетического контента предстает некий свод правил и политик конкретной цифровой платформы, который, в зависимости от ситуации, трактуется как заблагорассудится владельцами и операторами экосистемы. Таким образом, постановка цифровых платформ под плотный контроль в странах операционной деятельности — единственная на сегодняшний день мера воздействия в целях защиты общества от вредоносного контента, включая дипфейки. Государство в лице регулятора определяет критерии «правильного» и «неправильного» контента, а цифровая платформа принимает их к руководству и исполнению. В противном случае — крупный штраф или прекращение деятельности в национальной юрисдикции.

Доверяй, но проверяй

Если с методами противодействия вредоносным дипфейкам в технологической и юридической плоскости все более-менее понятно, то что может предпринять рядовой гражданин для того, чтобы не стать объектом сторонней манипуляции? В контексте цифрового контента прежде всего следует обратить внимание на следующие принципиальные моменты:

- необходимо осознавать, что мы живем в эпоху фейков и дезинформации;

- просмотренный «резонансный» контент желательно верифицировать в нескольких источниках;

- в случае с политическим контентом следует дождаться публичного заявления, и/или перепроверить информацию на официальных ресурсах;

- при просмотре графического контента излишняя пикселизация, дефекты, нечеткое или смазанное изображение свидетельствует о вероятном вмешательстве в видеоряд, поэтому доверяться увиденному без дополнительного подтверждения не следует;

- неестественные движения человека, мимика, подергивания лицевых мышц также говорят о вероятном редактировании видеоряда;

- несоответствия в телосложении, голосе, тоне, прическе известного человека (или известного только вам, если вы — целевой объект воздействия);

- смазанная граница замененного лица, различие в тенях, освещенности и оттенке кожи также выдают подделку.

Следует обращать внимание, на каком ресурсе размещено видео, не стоит доверять сомнительным и непроверенным источникам. Рекомендуется скептически относиться к любым неожиданно щедрым предложениям, исходящим от известных личностей. По мнению некоторых экспертов, неестественность в поведении человека на видео может вызывать у зрителей эффект «зловещей долины» (от англ. uncanny valley), выражающийся в появлении тревоги и неприязни к происходящему. Наше тело, в отличие от разума, нас редко обманывает и к его сигналам тоже имеет смысл прислушиваться.

В контексте вредоносных голосовых дипфейков общение с жертвой, как правило, строится вокруг денег (кредиты, долги, лотерея, инвестиции и пр.), что должно наталкивать человека на мысль о желании втянуть его в сомнительные схемы. Необходимо ясно и четко понимать, что именно от вас хотят, пытаясь задержать в разговоре эмоциональными или псевдонаучными репликами. Осознанность запускает наш внутренний механизм критического мышления, увеличивающий шанс выйти из-под любого манипуляционного воздействия.

Помните, каждый интернет-пользователь оставляет «цифровые следы», в том числе на форумах, сайтах различных сервисов и услуг, соцсетях. По возможности минимизируйте обнародование своих установочных данных (личных документов, почтовых адресов, телефонов, никнеймов, подписок, договорных и иных отношений с другими людьми, участие в группах по интересам и пр.). Это усложнит злоумышленникам сбор и анализ информации. Любому таргетированному воздействию с применением дипфейков и связанных передовых технологий, как правило, предшествует работа по изучению потенциальной жертвы.

***

Уже несколько лет дипфейк-технологии в том или ином виде вошли в нашу жизнь. Их не нужно бояться, их нужно знать. Информированность — ключ к минимизации рисков и угроз, игнорирование — прямая дорога на «минное поле» многочисленных дипфейк-ловушек. Так или иначе цифровизация нашей жизни будет продолжаться. В идеальном сценарии каждый новый технологический виток будет происходить после нивелирования негативных проявлений предыдущего. Однако на практике так происходит все реже. Повышение собственной цифровой грамотности позволит избежать подавляющего большинства технологических «мышеловок», поскольку практически весь деструктивный контент, в котором все большее значение отводится дипфейкам, ориентирован на неискушенного пользователя. Любой массовый синтетический контент только хочет казаться неотличимым от настоящего. На самом деле он имеет множество технологических и контекстных (логических) изъянов, увидеть которые не так сложно. Как в современном кинематографе мы с легкостью различаем реальных и «нарисованных» героев, какие бы совершенные технологии нам ни показывали, так и в жизни любой человек способен распознать абсолютное большинство дипфейков. Пока на технологическом и государственном уровнях не будет выстроен надежный периметр безопасности в сфере дипфейк-технологий, наша защита будет во многом зависеть от нас самих.

1. R. Chawla, Deepfakes: How a pervert shook the world, International Journal of Advance Research and Development, Vol 4, 2019

2. Машинное обучение — подмножество ИИ, связанное с созданием алгоритмов, которые могут изменять себя без вмешательства человека для получения желаемого результата путем подачи себя через структурированные данные. Глубокое обучение — подмножество машинного обучения, где алгоритмы создаются и функционируют аналогично машинному обучению, но существует множество уровней этих алгоритмов, каждый из которых обеспечивает различную интерпретацию данных, которые он передает. Такая сеть алгоритмов называется искусственными нейронными сетями.

3. N. Gardiner, Facial re-enactment, speech synthesis and the rise of the Deepfake. Edith Cowan University, Theses 2019.

4. Meta признана экстремистской организацией в России.

5. Данная технология имеет сходство с видеорегистраторами в автомобилях, а также с портативными камерами, которые носят на себе представители правоохранительных органов.

(Голосов: 24, Рейтинг: 4.46) |

(24 голоса) |

Никакое мировое лидерство невозможно при существующем уровне отставания в области разработки и развертывания «сверхглубоких» нейросетевых моделей

Этика ИИ в авангарде мировой повесткиВ ЮНЕСКО утвержден первый глобальный документ об этических аспектах искусственного интеллекта

Распространение социальных норм и ценностей в постпандемийном мире: от реактивного к проактивному подходуЧто и как регулировать?

Искусственный интеллект в процессе принятия внешнеполитических решенийВажно развивать ИИ как инструмент в процессе принятия внешнеполитических решений и не использовать эту технологию в качестве арбитра в международных делах